2024-01-13

【ComfyUI】LCM-LoRAで超高速化!シンプル解説!【やたら簡単】

LCM-LoRAを使うと画像生成を高速化できる!とにかくシンプル・簡単な解説を目指す!

LcM-LoRAとは

- 難しい話はナシにして、とにかく生成を高速化するモデル

- LoRAなので既存のチェックポイントをそのまま使える

- ただし使い方に少しクセがあるのでここをできるだけシンプルに解説

とにかくコレに関するシンプルなノード解説のページが存在しなかったため執筆。

前提条件

このページを読む上での前提条件

- このページは

ComfyUIを使う(webUIではない) - シンプル解説ゆえ、ComfyUIの基本の解説はしない

ComfyUI Managerがインストールしてあること

必要なもの

ComfyUI ManagerのInstall Modelsから

LCM LoRA SD1.5をインストール(SDXLを使う場合はLCM LoRA SDXL?未検証)

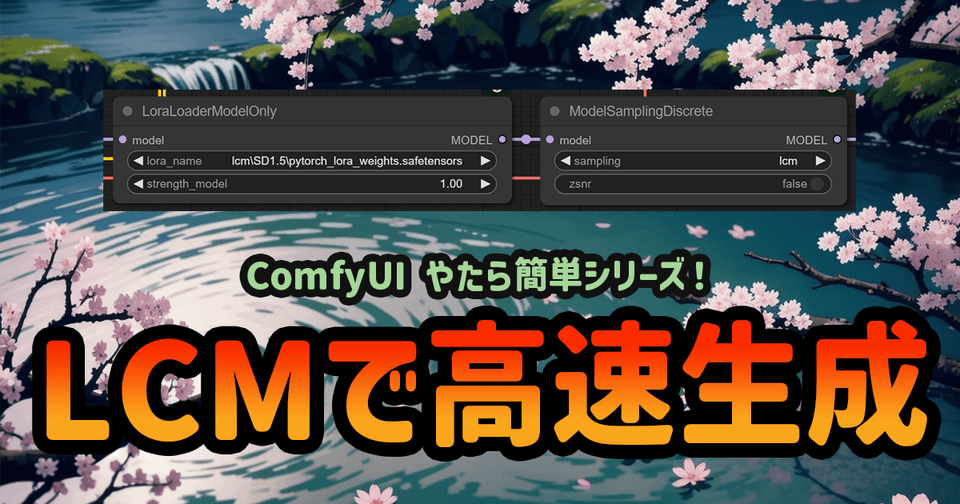

つなぎ方

恐らく最小構成は次。

1. LoaraLoaderModelOnly

LoaraLoaderModelOnly(検索名も同じ)を出してCheckpointのモデルを接続。

ここのlora_nameに上でDLしたモデルを設定する。

モデル名はpytorch_lora_weights.safetensorsになっているはず。

2. ModelSamplingDiscrete

ModelSamplingDiscrete(検索名も同じ)を配置しsamplingをlcmに設定する

なぜこれが必要なのかは分かっていない。無くてもなんとかなるが挿すのが基本の模様。

出る絵が悪くなる?

3. KSamplerの設定

ModelSamplingDiscreteからKSamplerのmodelに繋ぐ。

次に設定する

- Stepsを10以下にする(6~8ぐらいがおすすめ)

cfgを1-2のに設定するsampler_nameをlcmに設定するschedulerは割りと何でも良いがsimpleにしている人を多く見かける(一番軽い?

完成

あとは実行するだけ。

私の環境だと生成時間は半分程度になる。

これはAnimateDiffのような処理が重いノードの組み方と併用するとかなり有用なのではないだろうか。

参考:出た絵の比較

参考までにLCM-LoRAを使ったときとそうでないときを比較(RTX 3060)

| LCM-LoRA | 通常の生成 | |

|---|---|---|

| 生成時間 | 7.25秒 | 16.72秒 |

| 生成結果 |

|

|

LCMのほうがプロンプトに忠実で絵として完成している。

LCMがない方がディティールはあるが、書き込みきれてない感じ。人物も入ってしまう。

参考:使用感

個人的にAnimateDiffで使うとチェックポイントを変えても同じような絵が出がち。

まだ新しい技術だからか色々不具合もあるかもしれないのでこれだけ使うのではなく選択肢の一つとして考えたい。

この記事をシェア

謎の技術研究部 (謎技研)